Los primeros sensores de visión con IA

26 de mayo de 2020 ElectrónicaSony ha anunciado dos modelos de sensores de imagen que utilizan visión inteligente con procesamiento a alta velocidad y baja latencia.

Estos productos amplían las oportunidades de desarrollar cámaras equipadas con inteligencia artificial, abre el campo para una amplia gama de aplicaciones tanto en empresas de equipamiento industrial como minorista, y contribuye a construir sistemas óptimos conectados a la nube.

La generalización del Internet de las cosas (IoT) ha hecho posible que cualquier tipo de dispositivo pueda conectarse a la nube, haciendo común el uso de sistemas de procesamiento de la información donde esta se obtiene en dichos dispositivos y se procesa en la nube mediante IA. Por otro lado, el creciente volumen de información manejada en la nube plantea diversos problemas: el aumento de la latencia en la transmisión de datos dificulta el procesamiento de la información en tiempo real, así como problemas de seguridad de los usuarios relacionados con el almacenamiento en la nube de datos de identificación personal; y otros problemas como el aumento del consumo de energía y los costes de comunicación que conllevan los servicios en la nube.

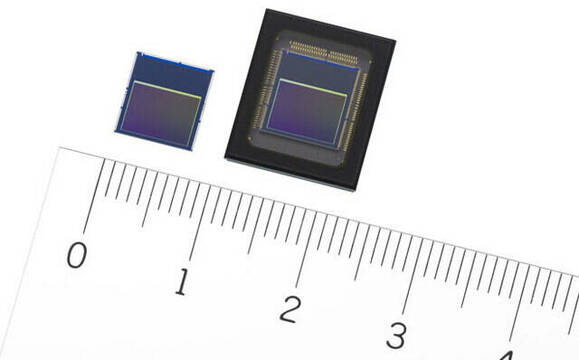

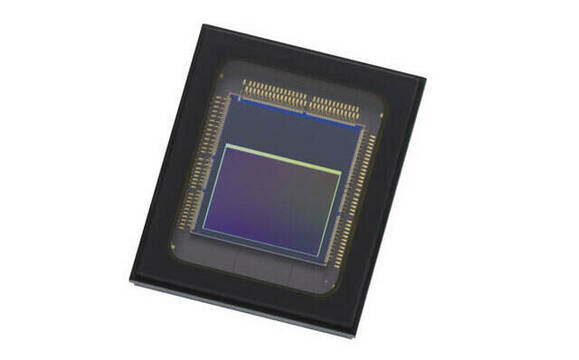

Estos nuevos sensores presentan una configuración por capas consistente en un chip de píxeles y otro chip de lógica. Son los primeros sensores de imagen del mundo equipados con funciones de análisis y procesamiento de imágenes con IA en el chip de lógica. La señal adquirida por el chip de píxeles se procesa usando IA en el propio sensor, lo que elimina la necesidad de usar procesadores de alto rendimiento o memoria externa, y permite el desarrollo de sistemas de inteligencia artificial en el propio dispositivo (en inglés, Edge AI). El sensor genera metadatos (información semántica que pertenece a los datos de la imagen) en lugar de la información de la imagen, lo que reduce el volumen de datos y los problemas de privacidad. Además, la capacidad de IA permite ofrecer distintas funcionalidades como el seguimiento de objetos en tiempo real con procesamiento de IA a alta velocidad. También se pueden elegir diferentes modelos de IA, reescribiendo la memoria interna según sean los requisitos del usuario o las condiciones en la ubicación donde se utiliza el sistema.

El chip de pixeles está retroiluminado y tiene aproximadamente 12,3 megapíxeles efectivos para capturar información en un amplio ángulo de visión. Además de la habitual circuitería lógica del sensor de imagen, el chip de lógica está equipado con un procesador digital de señal (DSP) original de Sony, dedicado al procesamiento de la señal mediante inteligencia artificial (IA) y memoria para el modelo IA. Esta configuración elimina la necesidad de procesadores de alto rendimiento o memoria externa, lo que lo hace ideal para sistemas Edge AI.

Salida de metadatos

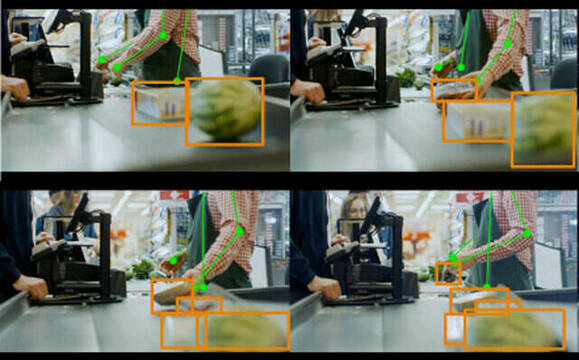

Las señales adquiridas por el chip de píxeles se ejecutan a través de un procesador de señal de imagen (ISP) y el procesamiento de inteligencia artificial se realiza en la etapa de procesamiento en el chip de lógica. La información extraída se genera en forma de metadatos, lo que reduce la cantidad de datos que se deben manejar. Puesto que no se muestra la información de la imagen, este sistema ayuda a reducir los riesgos de seguridad y a resolver los problemas de privacidad. Además de la imagen grabada por el sensor de imagen convencional, los usuarios pueden seleccionar el formato de salida de los datos según sus necesidades y usos, como imágenes en formato ISP (YUV/RGB) o imágenes de áreas específicas o ROI (regiones de interés).

Cuando se graba un vídeo con un sensor de imagen convencional, se necesita enviar datos de cada fotograma individual para el procesamiento con IA, lo que provoca una alta transmisión de datos y dificulta el rendimiento adecuado en tiempo real. Los nuevos sensores de Sony realizan el procesamiento ISP así como la IA a alta velocidad (procesamiento de 3,1 milisegundos para MobileNet V1) en el chip de lógica, por lo que pueden completar todo el proceso en cada fotograma de vídeo. Este diseño hace posible ofrecer seguimiento de objetos de alta precisión en tiempo real durante la grabación de vídeo.

Modelo de IA seleccionable

El usuario puede escribir los modelos de IA de su elección en la memoria integrada y puede reescribirlos y actualizarlos según sus requisitos o los requisitos de la ubicación donde se utilice el sistema. Por ejemplo, al instalar varias cámaras con este producto en un centro comercial, se puede usar de forma versátil un solo tipo de cámara en diferentes ubicaciones, circunstancias, momentos o propósitos. Cuando se instale en los accesos de entrada, se puede usar para contar la cantidad de visitantes que acceden a la misma; cuando se instala en el estante de una tienda, se puede usar para detectar escasez de existencias; cuando esté en el techo, para el mapeo térmico de los visitantes (para detectar los lugares donde se reúnen muchas personas), etcétera. Además, el modelo de IA de una cámara concreta se puede reescribir de uno que sirva para detectar mapas de calor a otro que pueda identificar el comportamiento del consumidor, y así sucesivamente.